Validazione o non validazione del Software…questo è il problema?

L’entrata in vigore dell’Ordinanza 3274-3431 prima, del D.M. 14 Gennaio 2008 successivamente e, nulla pensiamo cambierà con le revisione che verranno introdotte nelle prossime Norme Tecniche, ha fatto sì che il ruolo dell’analisi strutturale nell’ambito dell’ingegneria sismica diventasse di primaria importanza a tal punto da far pensare che il progettista non possa essere tale senza l’ausilio di un opportuno strumento di calcolo. Questa “è cosa buona” quando l’ingegnere “formato” domina lo strumento di calcolo “efficiente”.

Ma quando uno strutturista, un edile-architetto oppure anche un idraulico o un ambientale,…, si possono considerare che posseggano l’attributo di “formati”? Ma quando un software ad elementi finiti generico (“general purpose”) oppure orientato ai ponti, alla progettazione del nuovo come alla verifica ed adeguamento degli esistenti, si può dire che sia “efficiente”?

Rispondiamo per ora alla prima domanda. Come dicevamo prima, nell’ultimo decennio le metodologie numeriche di analisi hanno subito modifiche sostanziali nelle nuove norme tecniche. Scendiamo nel dettaglio: si è evoluti da metodologie lineari statiche (nel materiale e nella geometria solitamente anche a telaio bidimensionale) all’uso di modelli, spesso per non dire sempre tridimensionali, altamente non lineari (effetti del secondo ordine, parametri costitutivi di calcestruzzo ed acciaio, grandi deformazioni, ecc.). Per esempio se prima il legame dei materiali coinvolti era lineare, elastico, isotropo ed omogeneo e le procedure di analisi confondevano la configurazione indeformata con la deformata (i “piccoli spostamenti” della Scienza delle Costruzioni), ora si usa un modello di Menegotto-Pinto per l’acciaio insieme al legame di Mander a confinamento costante per il calcestruzzo a cui va aggiunta una analisi in grandi spostamenti (e rotazioni) che tenga conto degli effetti del secondo ordine!! Inoltre, va aggiunto, ad ulteriore complicazione, che lo studio di vulnerabilità degli edifici esistenti richiede di determinare nel modo più accurato la possibile la risposta strutturale non solo nei confronti delle azioni in condizione di esercizio, ma anche allo stato limite ultimo e che spesso l’analisi più efficace è la dinamica nonlineare ottenuta applicando almeno sette accelerogrammi spettrocompatibili da selezionare opportunamente. Quindi l’ingegnere strutturista non può, anzi non deve, “fidarsi” in maniera incontrollata dei risultati ottenuti e, di conseguenza, non deve “affidarsi” ciecamente al software strutturale impiegato, ma deve diventare un utilizzatore consapevole, preparato e critico di procedure numeriche sempre più complesse.

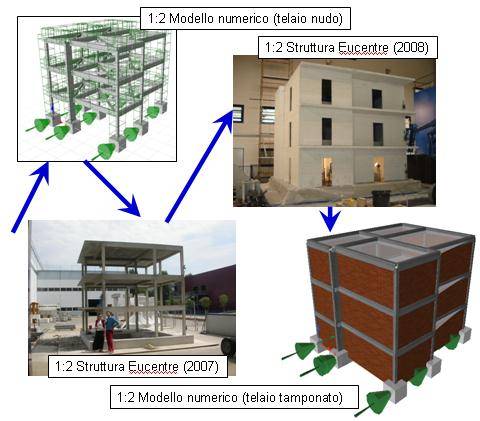

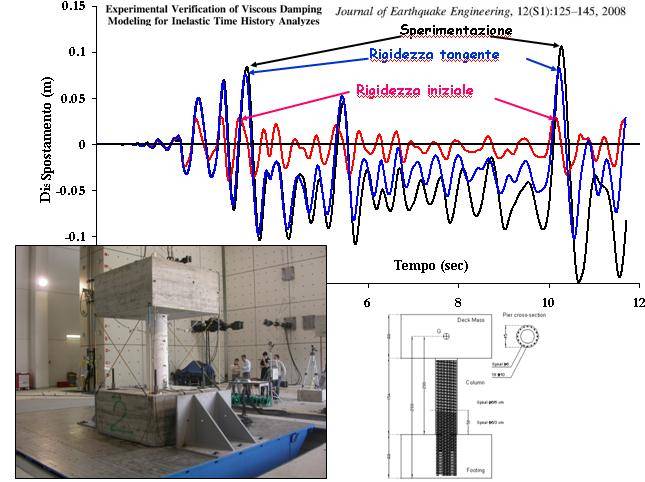

Questo significa che il nuovo strutturista deve essere capace di compiere scelte, secondo criteri scientifici, nel passare dalla struttura reale, al modello numerico attraverso una opportuna discretizzazione del continuo, come schematizzato in Figura 1, fino a giungere alla soluzione finale con le relative relazioni di calcolo. Durante questi delicati passaggi vengono compiute dal progettista delle scelte, più o meno consapevoli, che introducono nella procedura di analisi approssimazioni ed errori successivi che, se non adeguatamente pesati, controllati e criticamente tenuti in considerazioni, portano a risultati molto lontani dalla realtà fisica di partenza. Basti osservare in Figura 2 la differenza nella scelta della matrice di rigidezza iniziale o tangente in rapporto al reale comportamento rilevato sperimentalmente. Nell’idealizzare la struttura reale da progettare attraverso un modello matematico con un opportuno grado di dettaglio il professionista, previa visione accurata di tutto il materiale a disposizione (sezioni, prospetti, rilievi, ecc.), deve arrivare a decidere: geometria (bidimensionale o tridimensionale), vincoli, connessioni (elemento di elevata criticità nelle strutture prefabbricate come dimostrato nei passati eventi del 20 e 29 maggio in Emilia), carichi, masse (concentrate o distribuite), orizzontamenti (rigidi o flessibili), eccentricità locali e globali, interazioni con il suolo. Da aggiungere anche una delle approssimazioni maggiori richieste in questa fase: la scelta del materiale come riportato sopra.

Nelle nuove costruzioni un modello costitutivo lineare, elastico, isotropo ed omogeneo può essere sufficiente, mentre nel caso di verifica di edifici esistenti la trattazione della non linearità (sia nel materiale e ancora più nella geometria) diventa una richiesta obbligata. Successivamente l’analista numerico deve saper scegliere un approccio alle forze oppure agli spostamenti, considerando che la scelta dell’una o dell’altra alternativa non è assolutamente ininfluente. Basti pensare, nel non lineare, alla scelta di modellare travi e pilastri con elementi a plasticità diffusa (elementi fibra) in forza oppure in spostamento: la discretizzazione (numero di elementi) e l’integrazione delle equazioni risolventi (numero di punti di gauss) condiziona fortemente i risultati.

Come è possibile per il professionista districarsi tra queste innumerevoli scelte senza poi dover rifare innumerevoli volte il modello?

Partecipando a corsi di aggiornamento professionali con una propria specificità formativa principalmente rivolta a creare una figura competente nell’ambito appena descritto (in questa direzione va la formazione richiesta dal CNI con la 251/XVIII Sess. del 16 luglio 2013). E in caso di dubbio, avvalendosi anche di figure professionali con approfondite conoscenze numeriche e teoriche, trasversali ai diversi ambiti dell’ingegneria civile ed esperta di calcolo strutturale mediante l’impiego di differenti software di calcolo.

Inoltre, alla centralità del progettista, si devono affiancare Istituzioni e Centri di Ricerca atti a prendersi carico della scrittura di linee guida di supporto al professionista molto simili a quelle prodotte nel 1984, ma tuttora considerabili un caposaldo nel settore, da NAFEMS e intitolate “Guidelines to finite element practice”. Tutto ciò, insieme ad una esperienza prolungata sull’argomento, “validerebbe” l’ingegnere, ma questo non basta!!

La Validazione del Software

Infatti entra in gioco un nuovo protagonista, che introduce la seconda domanda fatta sopra, ed è proprio lo strumento di calcolo che deve sempre fornire un manuale utente, un manuale di utilizzo, una serie di esempi ed un testo teorico di riferimento, aggiornati, esaustivi, chiari e di immediato impiego.

Quindi alla “validazione” del progettista, si devono affiancare, lavorando di concerto, Istituzioni, Centri di Ricerca e in prima battuta software-house che devono avere fra i propri obiettivi la “validazione” dei codici tramite: casi studio analitici in letteratura scientifica, comparazione con altri solutori, ma soprattutto confronti con dati sperimentali che nell’ambito non lineare sono imprescindibili.

Esiste quindi un rapporto stretto e biunivoco tra validazione e sperimentazione, tra software e prove di laboratorio, che dovrebbe avere un obiettivo comune a varie figure coinvolte (ricercatori, progettisti, sviluppatori, professionisti): la scrittura del classico (almeno in ambito anglosassone) manuale di “Verification Report” che dovrebbe diventare un dovere fondamentale di ogni produttore, implementatore e distributore di software. Facili anche i capitoli che dovrebbero contenere: una introduzione, un primo paragrafo di confronto con calcoli a mano tipici della Scienza delle Costruzioni, un secondo capitolo di comparazione con i casi classici presenti in letteratura scientifica (come il telaio di Lee risalente al 1968 oppure la trave inclinata di Williams del 1964) ed infine una sezione di calibrazione con dati sperimentali sia a scala reale che ridotta. In questo modo si arriverebbe ad avere una buona valutazione della stabilità degli algoritmi coinvolti, del condizionamento delle matrici, della robustezza del solver, delle prestazioni richieste, etc.

Una seria ed opportuna implementazione operativa delle fasi tracciate in precedenza costituirebbe per il futuro una buona regolamentazione nel panorama confuso degli utilizzatori e distributori indiscriminati di “black box” a risultato garantito che hanno come vero e unico risultato garantito quello di assopire la principale dote dell’ingegnere, l’INGENIO che è anche la testata sulla quale sto scrivendo.

Figura 1. Schema del passaggio tra modello reale e discretizzazione ad elementi fibra per la comparazione/calibrazione con una prova sperimentale svolta in Eucentre.

Figura 2. Analisi dinamica non lineare: comparazione tra prova sperimentale (Eucentre) e simulazione numerica.